Live Caption es una de las mejores funciones de Android hasta la fecha, ya que utiliza el aprendizaje automático en el dispositivo para generar subtítulos para videos locales y clips web.

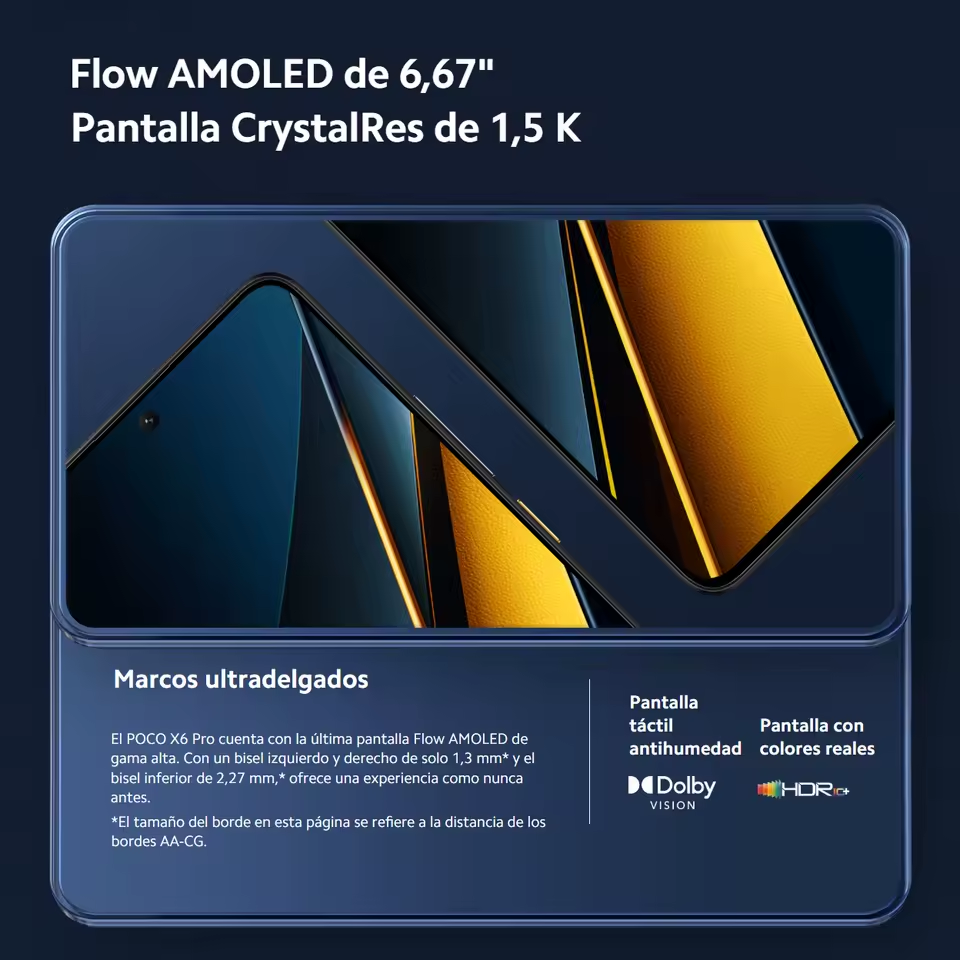

Xiaomi POCO X6 Pro 5G 8GB/256GB 12GB/512GB NFC EU Charger Global Version Teléfono móvil

Google ha publicado un entrada en el blog que detalla exactamente cómo funciona esta característica ingeniosa, y en realidad consta de tres modelos de aprendizaje automático en el dispositivo, para empezar.

Existe un modelo de transducción de secuencia de red neuronal recurrente (RNN-T) para el reconocimiento de voz, pero Google también está utilizando una red neuronal recurrente para predecir la puntuación.

El tercer modelo de aprendizaje automático en el dispositivo es una red neuronal convolucional (CNN) para eventos de sonido, como el canto de los pájaros, los aplausos y la música. Google dice que este tercer modelo de aprendizaje automático se deriva de su trabajo en la aplicación de accesibilidad Live Transcribe, que puede transcribir eventos de voz y sonido.

Reducir el impacto de Live Caption

La compañía dice que ha tomado una serie de medidas para reducir el consumo de batería y las demandas de rendimiento de Live Caption. Por un lado, el motor de reconocimiento automático de voz (ASR) solo se ejecuta cuando se detecta realmente la voz, en lugar de ejecutarse constantemente en segundo plano.

“Por ejemplo, cuando se detecta música y no hay voz en la transmisión de audio, aparecerá la etiqueta (MÚSICA) en la pantalla y se descargará el modelo ASR. El modelo ASR solo se vuelve a cargar en la memoria cuando el habla vuelve a estar presente en el flujo de audio «, explica Google en su publicación de blog.

Google también ha utilizado técnicas como la poda de conexiones neuronales (reducir el tamaño del modelo de voz), reducir el consumo de energía en un 50% y permitir que Live Caption se ejecute continuamente.

Google explica que los resultados del reconocimiento de voz se actualizan varias veces cada segundo a medida que se forma el subtítulo, pero la predicción de puntuación es diferente. El gigante de las búsquedas dice que ofrece predicciones de puntuación «en la cola del texto de la oración reconocida más recientemente» para reducir la demanda de recursos.

Live Caption ya está disponible en el Google Pixel 4 serie, y Google dice que estará disponible «pronto» en la serie Pixel 3 y otros dispositivos. La compañía dice que también está trabajando en soporte para otros idiomas y un mejor soporte para contenido de múltiples parlantes.