Google Pixel 4 es el primer dispositivo Pixel con más de una cámara trasera, lo que marca un movimiento muy retrasado para la compañía en un momento en que se esperan cámaras triples.

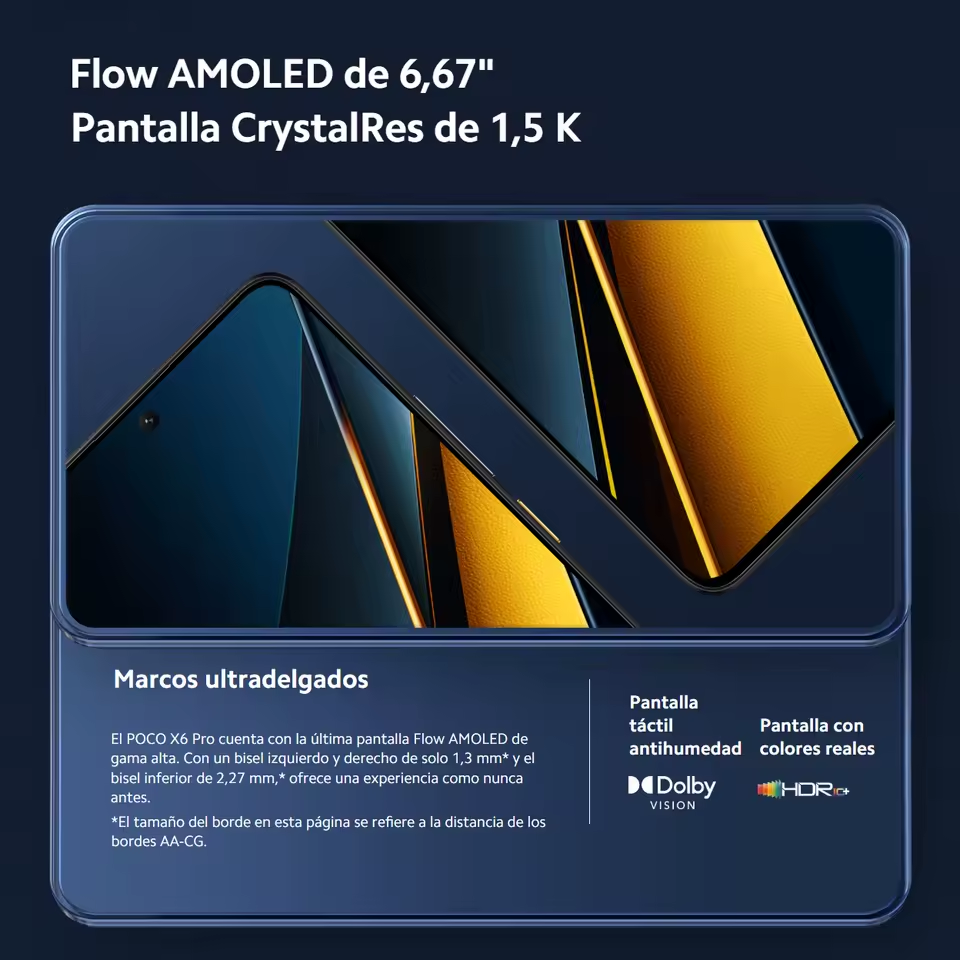

Xiaomi POCO X6 Pro 5G 8GB/256GB 12GB/512GB NFC EU Charger Global Version Teléfono móvil

Google pudo hacer magia con los teléfonos Pixel de una sola cámara, particularmente con el modo vertical, que tradicionalmente requiere una segunda cámara trasera. Ahora, la compañía ha llevado a su Blog de IA para explicar cómo el modo vertical de Pixel 4 mejora las cosas.

Resulta que el Pixel 4 todavía usa la misma tecnología de modo de retrato de una sola cámara que los píxeles anteriores. Los teléfonos más antiguos usaban tecnología de enfoque automático de doble píxel para el modo vertical, dividiendo cada píxel en la cámara principal de 12MP por la mitad. Cada mitad del píxel de la cámara ve un punto de vista ligeramente diferente (particularmente en el fondo). Esto permite una estimación aproximada de la profundidad al encontrar los píxeles correspondientes entre los dos puntos de vista.

Sin embargo, esta solución tiene sus limitaciones, señala Google en el blog, ya que los píxeles dobles se limitan a una pequeña cámara única. Esto significa que la diferencia entre los puntos de vista es extremadamente pequeña, y realmente desea puntos de vista más amplios para una mejor estimación de la profundidad.

Google descubre cámaras de teleobjetivo

Aquí es donde entra en juego el teleobjetivo del Pixel 4, ya que Google señala que la distancia entre las cámaras principal y teleobjetivo es de 13 mm. Google ilustra la diferencia entre lo que ven los píxeles duales y lo que ven las cámaras duales en el GIF a continuación. Observe cómo hay un ligero desplazamiento vertical con píxeles dobles (L), a diferencia del desplazamiento muy notable con cámaras duales.

Las cámaras duales presentan un desafío importante a este respecto, ya que los píxeles en una vista pueden no encontrarse en la otra vista (debido a los puntos de vista más amplios). Y es por eso que Google no está descartando el enfoque heredado del Modo Retrato en el Pixel 4.

«Por ejemplo, los píxeles de fondo inmediatamente a la derecha del hombre en la imagen de la cámara principal no tienen píxeles correspondientes en la imagen de la cámara secundaria. Por lo tanto, no es posible medir el paralaje para estimar la profundidad de estos píxeles cuando se usan solo cámaras duales ”, se lee en un extracto del blog de IA. «Sin embargo, estos píxeles aún se pueden ver en las vistas de píxeles dobles (izquierda), lo que permite una mejor estimación de la profundidad en estas regiones».

Sin embargo, las cámaras duales también ayudan a lidiar con los llamados problema de apertura, lo que hace que la estimación de profundidad de líneas verticales sea más desafiante. Además, Google también entrenó a su red neuronal para calcular la profundidad lo suficientemente bien cuando solo está disponible un método (doble píxel o cámaras duales). La compañía dice que el teléfono usa ambos métodos de mapeo de profundidad cuando la cámara está al menos a 20 cm del sujeto (la distancia mínima de enfoque para la cámara de teleobjetivo).

Finalmente, Google dice que también ha trabajado para que el bokeh se destaque más, para que pueda ver más claramente los discos bokeh en el fondo de una toma. Echa un vistazo a las imágenes de arriba para tener una mejor idea del producto terminado.

Esta no es la única tecnología nueva ahora en los teléfonos Google Pixel, ya que la compañía detalló previamente cómo funciona su modo de astrofotografía. De cualquier manera, esperamos que Google siga superando los límites de la fotografía computacional en 2020.